Quizá hayas leído últimamente noticias sobre técnicas automatizadas informáticamente que tal vez te hayan llamado la atención. Programas que colorean imágenes en blanco y negro con un efecto creíble. Grabaciones mudas a las que un programa añade sonidos realistas. Software que clasifica imágenes y reconoce lo que estas muestran. Otros que reconocen palabras y frases escritas a mano. Pies de foto escritos por inteligencias artificiales. Incluso cuentos y otros textos de ficción creados por máquinas.

Quizá hayas leído últimamente noticias sobre técnicas automatizadas informáticamente que tal vez te hayan llamado la atención. Programas que colorean imágenes en blanco y negro con un efecto creíble. Grabaciones mudas a las que un programa añade sonidos realistas. Software que clasifica imágenes y reconoce lo que estas muestran. Otros que reconocen palabras y frases escritas a mano. Pies de foto escritos por inteligencias artificiales. Incluso cuentos y otros textos de ficción creados por máquinas.

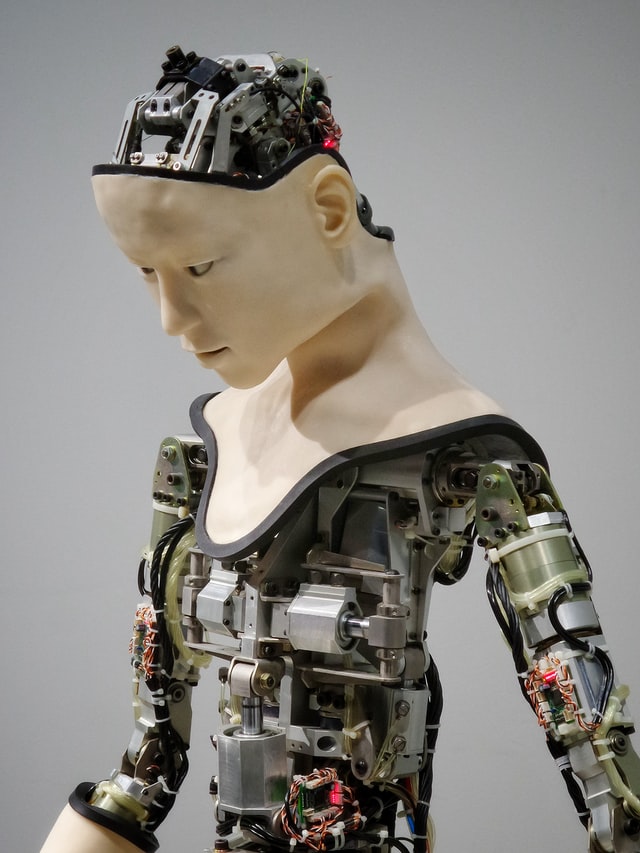

Lo que hasta hace poco parecía fuente de historias de ciencia ficción, o apenas unos desarrollos estrambóticos al margen de la sociedad, ha pasado a ser una parte fundamental de la tecnología doméstica. Hablamos del deep learning, técnica de aprendizaje de las inteligencias artificiales que permite numerosas aplicaciones en nuestra vida diaria.

Cuando hablamos con los asistentes personales de nuestros teléfonos, por ejemplo a través del Siri de iPhone, el Cortana de Microsoft o el Alexa de Amazon, cuando leemos que se ha mejorado el protocolo de traducción de Google Translate o el de orientación de los coches autónomos de Google y otras compañías… estamos interactuando con inteligencias artificiales que están aprendiendo constantemente.

¿De dónde viene el deep learning?

En el campo de la inteligencia artificial hay una subcategoría, llamada aprendizaje de máquinas, que contiene los saberes sobre la mejora de las máquinas en sus funciones mediante el aprendizaje. El Deep Learning, también llamado redes neuronales profundas, es una rama de este tipo de aprendizaje. Se puede definir como una serie de algoritmos que permiten a un software entrenarse a través de la exposición a vastas cantidades de datos.

La autonomía del programa es una de las claves del deep learning: nadie introduce nuevos conocimientos. Los informáticos simplemente le facilitan al programa el algoritmo de aprendizaje para que funcione por sí solo. Los datos entran durante la “fase de aprendizaje”, mediante esos algoritmos, pasan por varias capas de procesamiento y finalmente, el programa devuelve el resultado. Hablamos de máquinas que aprenden y se enseñan a sí mismas, de programas que escriben programas.

El concepto de deep learning no es nada nuevo. Se remonta a los años cincuenta, y mucho del trabajo en algoritmos ya estaba encauzado desde los ochenta y noventa. Lo que ha cambiado ahora, lo que ha posibilitado la revolución, es el incremento en capacidad de los equipos y en la cantidad de datos disponibles.

No hablamos solo de internet o de los dispositivos más comunes. Las inteligencias artificiales con capacidades de aprendizaje están revolucionando ya la vida en todos sus ámbitos. El director del departamento de aprendizaje de máquinas de Amazon, Ralf Herbrich, lo ha resumido así: “estamos en la edad de oro del aprendizaje de máquinas e inteligencia artificial”.

Dado que la cuestión fundamental para que esta tecnología avance son los datos a los que puede acceder la inteligencia artificial, no es de extrañar que los principales inversores en ella hayan sido las firmas más potentes en tecnología de la información: Google, Microsoft, Facebook y Baidu. Menos Baidu, y junto a Amazon e IBM, estos grupos se han asociado en Londres para acordar una serie de conductas éticas y buenas prácticas.

Es interesante, y probablemente no pasa a menudo, que compañías tan grandes se pongan de acuerdo en algo para ramas de negocio tan potentes. Veamos qué tienen previsto algunas de ellas para el presente y el futuro de las aplicaciones de deep learning.

Microsoft

Aunque hoy en día esté un poco en el furgón de cola de la innovación, lo cierto es que los padres de Windows introdujeron el deep learning en sus productos de reconocimiento de voz en el lejano 2011. Para Bill Gates, lo ha dicho en un Ask me anything de Reddit, es una de las prioridades. Desde entonces, han destacado en el desarrollo de redes neuronales para la búsqueda de imágenes y traducción.

La compañía del buscador aúna más de mil proyectos de deep learning, incluyendo avances para Android, para su buscador, Gmail, traducciones, Youtube, mapas y coches autónomos. Desde el año 2015, Google ha estado creando sus propios chips para avanzar en sus proyectos.

Google Translate quizá haya sido el servicio más comentado. Hasta ahora, el traductor funcionaba a base de dividir el texto en frases y palabras. Ahora, gracias a las técnicas de deep learning, el programa traduce el texto completo, interpretándolo como un todo. Con ello se han reducido los errores en un 60%. Y es treinta veces más rápido. Esto no quiere decir que sea un perfecto. Pero se van acercando, y en Google son optimistas acerca de sus posibilidades.

¿Recuerdas la victoria de Deep Blue sobre Kasparov, en un torneo de ajedrez? En marzo de 2016, una inteligencia llamada AlphaGo venció a Lee Sedol, campeón de Go, por cuatro juegos a uno. AlphaGo pertenece a DeepMind, compañía adquirida por Google en 2014. Al contrario que Deep Blue, que venía preprogramado, AlphaGo aprendió a jugar a base de observar a grandes maestros del juego en acción.

DeepMind está sirviendo para otra cosa: su trabajo ha mejorado la eficiencia de los centros de datos de Google en un quince por ciento, lo que significa ahorro económico y energético. La empresa y el medio ambiente ganan por igual.

El gigante de Zuckerberg tiene, por supuesto, su propio laboratorio de desarrollo de inteligencia artificial. Las redes neuronales de Facebook traducen en torno a 2 mil millones de posts diarios, a más de 40 idiomas. Ochocientos millones de usuarios los leen cada día. También están trabajando en reconocimiento y clasificación de imágenes. Uno de sus proyectos consiste en un sistema de etiquetado o pies de página para imágenes mediante voz, que serviría para explicar a usuarios invidentes qué muestra una imagen.

Baidu

Andrew Ng, antaño jefe del proyecto Google Brain, pasó en 2014 a Baidu, y lidera ahora su laboratorio de investigación de deep learning. Sus redes neuronales comprenden el reconocimiento de voz, traducción, búsqueda de imágenes y un proyecto de coche autónomo. Baidu estima que el número de usuarios que se relacionan con el buscador a través de voz se ha triplicado en año y medio.

IBM

Fiel a su vía de negocio de los últimos años, IBM realmente no diseña programas que se beneficien del deep learning, sino que se enfoca a apoyar el deep learning en sí. De esta manera han anunciado True North, un chip que funciona como plataforma para deep learning, con unas capacidades inspiradas en el funcionamiento del cerebro. True North es realmente rápido: puede analizar entre 1200 y 1600 fotogramas en un segundo.

Pero quizá el proyecto más célebre de IBM sea Watson, la inteligencia artificial que venció a dos campeones del concurso de televisión Jeopardy. Una treintena de servicios asociados a Watson se van a beneficiar del aprendizaje via deep learning.

Intel

Intel quizá no suene tanto como las anteriores, pero ha trascendido su adquisición de Nervana Systems, compañía de deep learning, para el desarrollo de un coche autónomo.

Pero el deep learning no solo está al alcance de los nombres más poderosos. Pequeñas y medianas empresas también están haciendo uso de él para los fines más singulares, como por ejemplo en investigación médica.

La startup Enlitic la usa para analizar radiografías y escáneres con más precisión que un radiólogo y más fiabilidad para clasificar los resultados como benignos o malignos. En esta cuestión, cantidad equivale a calidad. Una inteligencia artificial puede registrar, estudiar y comparar millones de radiografías, muchas más de las que un médico podrá ver en su vida.

Merck y Atomwise están trabajando –a veces de manera conjunta- en desarrollos medicinales. Freenome está examinando muestras de sangre para mejorar los diagnósticos de cáncer.

A pesar de que estos conceptos tienen ya unos cuantos años a la espalda, da la impresión de que el deep learning y su desarrollo en las inteligencias artificiales acaba de empezar y que tiene un futuro brillante para los años venideros. Casi cualquier ámbito de la vida diaria parece que podría beneficiarse de ello. El límite de estos avances va a ser la imaginación de los desarrolladores porque la pieza final del puzzle, la capacidad de los equipos, se está resolviendo por sí sola.